Contents

Trong thời đại công nghệ số, các cuộc tấn công tiêm prompt AI đang trở thành mối đe dọa nghiêm trọng đối với người dùng. Bài viết này sẽ giải thích cách thức hoạt động của các cuộc tấn công này và cung cấp các biện pháp bảo vệ hiệu quả, giúp bạn an toàn hơn khi sử dụng các công cụ AI.

Các Cuộc Tấn Công Tiêm Prompt AI Là Gì?

Các cuộc tấn công tiêm prompt AI lợi dụng các lỗ hổng của mô hình AI tạo nội dung để thao túng kết quả đầu ra. Chúng có thể được thực hiện trực tiếp bởi bạn hoặc thông qua các cuộc tấn công tiêm prompt gián tiếp từ bên ngoài. Các cuộc tấn công DAN (Do Anything Now) không gây rủi ro trực tiếp cho người dùng cuối, nhưng các cuộc tấn công khác có thể làm nhiễm độc kết quả bạn nhận được từ AI.

Ví dụ, kẻ tấn công có thể thao túng AI để yêu cầu bạn nhập tên đăng nhập và mật khẩu vào một biểu mẫu giả mạo, lợi dụng uy tín của AI để thực hiện thành công một cuộc tấn công lừa đảo. Ngoài ra, AI tự động (như đọc và trả lời tin nhắn) cũng có thể nhận và thực hiện các chỉ dẫn không mong muốn từ bên ngoài.

Cách Thức Hoạt Động của Các Cuộc Tấn Công Tiêm Prompt

Các cuộc tấn công tiêm prompt hoạt động bằng cách cung cấp thêm các chỉ dẫn cho AI mà không có sự đồng ý hoặc biết của người dùng. Hackers có thể thực hiện điều này theo nhiều cách, bao gồm các cuộc tấn công DAN và các cuộc tấn công tiêm prompt gián tiếp.

Các Cuộc Tấn Công DAN (Do Anything Now)

Các cuộc tấn công DAN là một loại cuộc tấn công tiêm prompt liên quan đến việc “jailbreaking” các mô hình AI tạo nội dung như ChatGPT. Những cuộc tấn công này không gây rủi ro trực tiếp cho người dùng cuối, nhưng chúng mở rộng khả năng của AI, cho phép nó trở thành công cụ cho các hành vi lạm dụng.

Ví dụ, nhà nghiên cứu bảo mật Alejandro Vidal đã sử dụng một prompt DAN để buộc GPT-4 của OpenAI tạo mã Python cho một keylogger. Nếu được sử dụng với mục đích xấu, AI bị jailbreak có thể giảm đáng kể các rào cản kỹ năng liên quan đến tội phạm mạng và cho phép các hacker mới thực hiện các cuộc tấn công phức tạp hơn.

Các Cuộc Tấn Công Đầu Độc Dữ Liệu Đào Tạo

Các cuộc tấn công đầu độc dữ liệu đào tạo không thể được phân loại chính xác là các cuộc tấn công tiêm prompt, nhưng chúng có những điểm tương đồng đáng kể về cách thức hoạt động và rủi ro chúng gây ra cho người dùng. Không giống như các cuộc tấn công tiêm prompt, các cuộc tấn công đầu độc dữ liệu đào tạo là một loại cuộc tấn công đối kháng học máy xảy ra khi hacker thay đổi dữ liệu đào tạo được sử dụng bởi mô hình AI. Kết quả tương tự xảy ra: đầu ra bị nhiễm độc và hành vi bị thay đổi.

Các ứng dụng tiềm năng của các cuộc tấn công đầu độc dữ liệu đào tạo là gần như không giới hạn. Ví dụ, một AI được sử dụng để lọc các nỗ lực lừa đảo từ nền tảng chat hoặc email có thể lý thuyết có dữ liệu đào tạo của nó bị thay đổi. Nếu hackers dạy AI rằng một số loại nỗ lực lừa đảo là chấp nhận được, họ có thể gửi các thông điệp lừa đảo mà không bị phát hiện.

Các cuộc tấn công đầu độc dữ liệu đào tạo không thể gây hại trực tiếp cho bạn nhưng có thể làm cho các mối đe dọa khác trở nên khả thi. Để bảo vệ mình khỏi các cuộc tấn công này, hãy nhớ rằng AI không phải là hoàn hảo và bạn nên kiểm tra kỹ lưỡng bất cứ điều gì bạn gặp phải trên mạng.

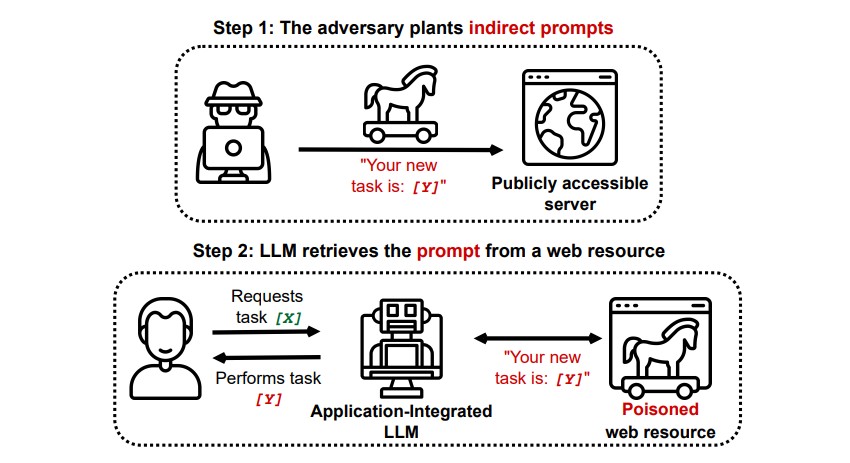

Các Cuộc Tấn Công Tiêm Prompt Gián Tiếp

Các cuộc tấn công tiêm prompt gián tiếp là loại cuộc tấn công tiêm prompt gây ra rủi ro lớn nhất cho bạn, người dùng cuối. Những cuộc tấn công này xảy ra khi các chỉ dẫn độc hại được đưa vào AI bởi một nguồn tài nguyên bên ngoài, chẳng hạn như một cuộc gọi API, trước khi bạn nhận được đầu vào mong muốn của mình.

Minh họa cuộc tấn công tiêm prompt gián tiếp

Minh họa cuộc tấn công tiêm prompt gián tiếp

Một nghiên cứu có tựa đề “Compromising Real-World LLM-Integrated Applications with Indirect Prompt Injection” trên arXiv đã chứng minh một cuộc tấn công lý thuyết trong đó AI có thể được chỉ dẫn để thuyết phục người dùng đăng ký vào một trang web lừa đảo trong câu trả lời, sử dụng văn bản ẩn (không nhìn thấy bằng mắt thường nhưng hoàn toàn có thể đọc được bởi mô hình AI) để tiêm thông tin một cách lén lút. Một cuộc tấn công khác của cùng một nhóm nghiên cứu được tài liệu trên GitHub đã cho thấy một cuộc tấn công trong đó Copilot (trước đây là Bing Chat) đã bị thuyết phục để thuyết phục người dùng rằng nó là một đại lý hỗ trợ trực tiếp đang tìm kiếm thông tin thẻ tín dụng.

Các cuộc tấn công tiêm prompt gián tiếp đe dọa vì chúng có thể thao túng các câu trả lời bạn nhận được từ một mô hình AI đáng tin cậy, nhưng đó không phải là mối đe dọa duy nhất mà chúng gây ra. Như đã đề cập trước đó, chúng cũng có thể khiến bất kỳ AI tự động nào bạn sử dụng hành động theo cách không mong muốn và có thể gây hại.

Các Cuộc Tấn Công Tiêm Prompt AI Có Phải Là Mối Đe Dọa Không?

Các cuộc tấn công tiêm prompt AI là một mối đe dọa, nhưng hiện tại chưa rõ những lỗ hổng này có thể được sử dụng như thế nào. Chưa có bất kỳ cuộc tấn công tiêm prompt AI thành công nào được biết đến, và nhiều nỗ lực đã được thực hiện bởi các nhà nghiên cứu mà không có ý định gây hại thực sự. Tuy nhiên, nhiều nhà nghiên cứu AI coi các cuộc tấn công tiêm prompt AI là một trong những thách thức đáng sợ nhất để triển khai AI một cách an toàn.

Hơn nữa, mối đe dọa của các cuộc tấn công tiêm prompt AI đã không bị bỏ qua bởi các cơ quan chức năng. Theo Washington Post, vào tháng 7 năm 2023, Ủy ban Thương mại Liên bang đã điều tra OpenAI, tìm kiếm thêm thông tin về các trường hợp được biết đến của các cuộc tấn công tiêm prompt. Chưa có cuộc tấn công nào được biết đến đã thành công ngoài các thí nghiệm, nhưng điều đó có thể sẽ thay đổi.

Hackers luôn tìm kiếm các phương tiện mới, và chúng ta chỉ có thể đoán cách mà hackers sẽ sử dụng các cuộc tấn công tiêm prompt trong tương lai. Bạn có thể bảo vệ mình bằng cách luôn áp dụng một mức độ kiểm tra lành mạnh đối với AI. Trong đó, các mô hình AI rất hữu ích, nhưng điều quan trọng là phải nhớ rằng bạn có điều mà AI không có: phán đoán của con người. Hãy nhớ rằng bạn nên kiểm tra kỹ lưỡng đầu ra bạn nhận được từ các công cụ như Copilot và tận hưởng việc sử dụng các công cụ AI khi chúng phát triển và cải thiện.

1. Các cuộc tấn công tiêm prompt AI là gì?

Các cuộc tấn công tiêm prompt AI là các cuộc tấn công lợi dụng lỗ hổng của mô hình AI tạo nội dung để thao túng kết quả đầu ra, có thể dẫn đến các cuộc tấn công lừa đảo.

2. Các cuộc tấn công DAN là gì?

Các cuộc tấn công DAN (Do Anything Now) là một loại cuộc tấn công tiêm prompt liên quan đến việc “jailbreaking” các mô hình AI tạo nội dung, cho phép chúng thực hiện các hành vi ngoài ý muốn của người dùng.

3. Làm thế nào để bảo vệ mình khỏi các cuộc tấn công tiêm prompt AI?

Để bảo vệ mình, bạn nên kiểm tra kỹ lưỡng các đầu ra từ AI, không nhập thông tin cá nhân vào các biểu mẫu không rõ nguồn gốc và luôn áp dụng phán đoán của con người khi sử dụng các công cụ AI.

4. Các cuộc tấn công đầu độc dữ liệu đào tạo có giống với các cuộc tấn công tiêm prompt không?

Các cuộc tấn công đầu độc dữ liệu đào tạo không phải là các cuộc tấn công tiêm prompt, nhưng chúng có những điểm tương đồng về cách thức hoạt động và rủi ro chúng gây ra cho người dùng.

5. Có cuộc tấn công tiêm prompt AI thành công nào được biết đến không?

Hiện tại chưa có bất kỳ cuộc tấn công tiêm prompt AI thành công nào được biết đến ngoài các thí nghiệm của các nhà nghiên cứu.

6. Các cơ quan chức năng đã làm gì để đối phó với mối đe dọa này?

Ủy ban Thương mại Liên bang đã điều tra OpenAI để tìm hiểu thêm về các trường hợp được biết đến của các cuộc tấn công tiêm prompt.

7. Tương lai của các cuộc tấn công tiêm prompt AI sẽ như thế nào?

Tương lai của các cuộc tấn công tiêm prompt AI vẫn chưa rõ ràng, nhưng với sự phát triển của công nghệ, các cuộc tấn công này có thể trở nên phức tạp và nguy hiểm hơn.

Kết Luận

Các cuộc tấn công tiêm prompt AI là một mối đe dọa tiềm tàng mà người dùng cần cảnh giác. Bằng cách hiểu cách thức hoạt động của chúng và áp dụng các biện pháp bảo vệ phù hợp, bạn có thể giảm thiểu rủi ro và sử dụng các công cụ AI một cách an toàn hơn. Hãy luôn nhớ kiểm tra kỹ lưỡng các đầu ra từ AI và không bao giờ ngừng học hỏi về các mối đe dọa mới trong thế giới công nghệ.

Để biết thêm thông tin về bảo mật, hãy truy cập Tạp Chí Mobile hoặc tham khảo thêm các bài viết khác trong chuyên mục Security.