Contents

- Giới Thiệu Về Chat with RTX

- Yêu Cầu Hệ Thống Để Cài Đặt Chat with RTX

- Cách Tải và Cài Đặt Chat with RTX

- Bước 1: Tải File ZIP của Chat with RTX

- Bước 2: Giải Nén File ZIP

- Bước 3: Cài Đặt Chat with RTX

- Cách Sử Dụng Chat with RTX

- Bước 1: Tạo Thư Mục RAG

- Bước 2: Thiết Lập Môi Trường

- Bước 3: Đặt Câu Hỏi Cho Chat with RTX

- Bước 4: Tính Năng Bổ Sung

- Đánh Giá Chat with RTX

- Giải Pháp Nếu Không Có GPU RTX 30 hoặc 40 Series

- Kết Luận

Giới Thiệu Về Chat with RTX

Chat with RTX là một chatbot AI do Nvidia phát triển, cho phép bạn chạy mô hình ngôn ngữ lớn (LLM) trực tiếp trên máy tính cá nhân của mình. Không cần kết nối internet, bạn có thể sử dụng Chat with RTX để tương tác với AI một cách an toàn và hiệu quả. Chat with RTX sử dụng TensorRT-LLM, RTX acceleration và mô hình Mistral 7B để đảm bảo hiệu suất cao và chất lượng phản hồi tương đương với các chatbot AI trực tuyến khác. Ngoài ra, tính năng retrieval-augmented generation (RAG) cho phép chatbot đọc và phân tích các tệp của bạn, từ đó cung cấp câu trả lời cá nhân hóa dựa trên dữ liệu bạn cung cấp.

Yêu Cầu Hệ Thống Để Cài Đặt Chat with RTX

Để cài đặt và sử dụng Chat with RTX, máy tính của bạn cần đáp ứng các yêu cầu tối thiểu sau:

- GPU RTX 30-Series hoặc 40-Series

- 16GB RAM

- 100GB dung lượng lưu trữ trống

- Hệ điều hành Windows 11

Cách Tải và Cài Đặt Chat with RTX

Bước 1: Tải File ZIP của Chat with RTX

Bạn có thể tải file ZIP của Chat with RTX từ trang web chính thức của Nvidia. File này có dung lượng khoảng 35GB.

- Tải xuống: Chat with RTX (Miễn phí—35GB)

Bước 2: Giải Nén File ZIP

Sau khi tải xuống, bạn cần giải nén file ZIP. Bạn có thể sử dụng công cụ như 7Zip hoặc nhấp đúp vào file và chọn Extract All.

Bước 3: Cài Đặt Chat with RTX

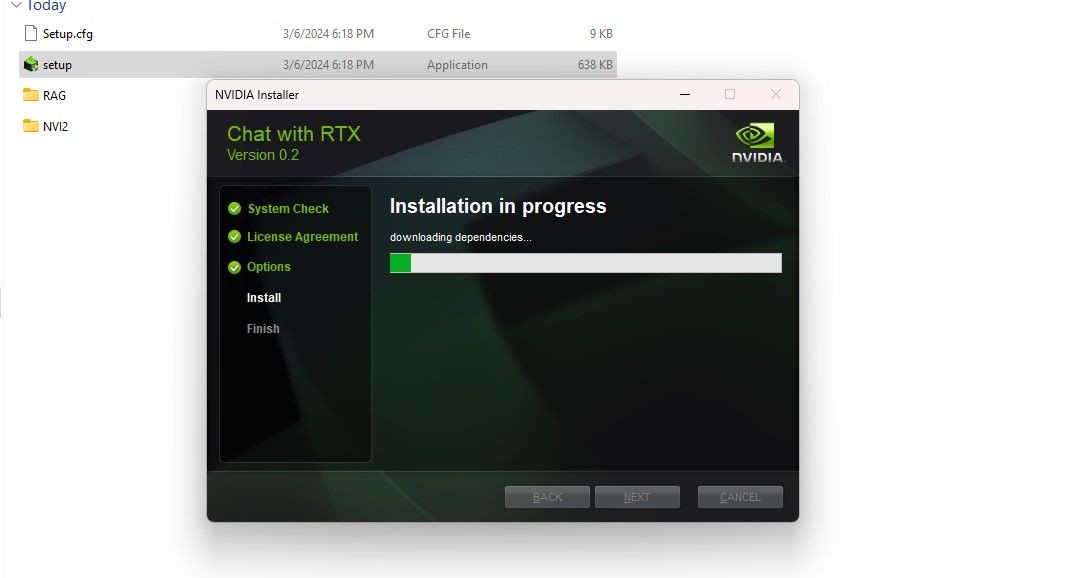

Mở thư mục đã giải nén và nhấp đúp vào setup.exe. Làm theo hướng dẫn trên màn hình và chọn tất cả các tùy chọn trong quá trình cài đặt tùy chỉnh. Sau khi nhấn Next, trình cài đặt sẽ tải xuống và cài đặt LLM cùng với tất cả các phụ thuộc cần thiết.

Quá trình cài đặt Chat with RTX

Quá trình cài đặt Chat with RTX

Quá trình cài đặt có thể mất một khoảng thời gian do lượng dữ liệu lớn cần tải xuống và cài đặt. Sau khi hoàn tất, nhấn Close để kết thúc quá trình cài đặt.

Cách Sử Dụng Chat with RTX

Bước 1: Tạo Thư Mục RAG

Để sử dụng tính năng RAG của Chat with RTX, bạn cần tạo một thư mục mới để lưu trữ các tệp mà bạn muốn AI phân tích. Sau khi tạo thư mục, đặt các tệp dữ liệu của bạn vào đó. Các tệp này có thể bao gồm tài liệu, PDF, văn bản và video. Tuy nhiên, bạn nên hạn chế số lượng tệp trong thư mục để không ảnh hưởng đến hiệu suất của chatbot.

Bước 2: Thiết Lập Môi Trường

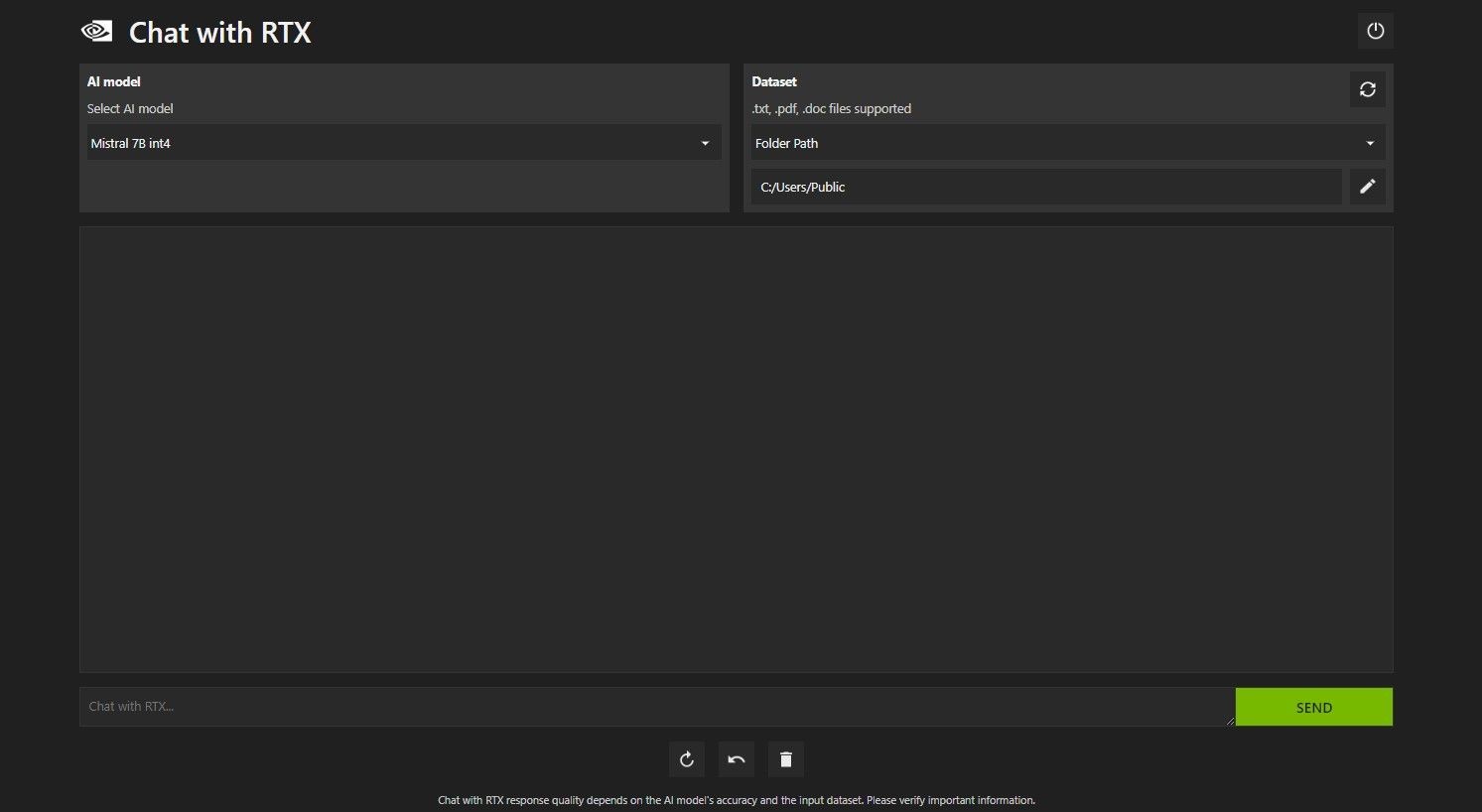

Mở Chat with RTX. Giao diện sẽ trông như hình dưới đây.

Giao diện Chat with RTX

Giao diện Chat with RTX

Trong phần Dataset, chọn Folder Path. Nhấp vào biểu tượng chỉnh sửa (biểu tượng bút) và chọn thư mục chứa các tệp bạn muốn Chat with RTX đọc. Bạn cũng có thể thay đổi mô hình AI nếu có các tùy chọn khác (hiện tại chỉ có Mistral 7B).

Bước 3: Đặt Câu Hỏi Cho Chat with RTX

Bạn có thể sử dụng Chat with RTX như một chatbot AI thông thường hoặc tận dụng tính năng RAG để cá nhân hóa câu trả lời. Ví dụ, bạn có thể hỏi về lịch trình của mình nếu đã cung cấp tệp PDF chứa lịch trình, lịch làm việc, sự kiện, v.v.

Đặt câu hỏi cá nhân cho Chat with RTX

Đặt câu hỏi cá nhân cho Chat with RTX

Chat with RTX có thể đọc qua các tài liệu pháp lý và tóm tắt, tạo mã phù hợp với chương trình bạn đang phát triển, hoặc cung cấp các điểm nổi bật về video mà bạn quá bận để xem.

Bước 4: Tính Năng Bổ Sung

Ngoài việc phân tích các tệp địa phương, bạn có thể sử dụng Chat with RTX để phân tích video trên YouTube. Chọn YouTube URL trong phần Dataset, sao chép URL video YouTube bạn muốn phân tích và dán vào ô dưới menu thả xuống. Sau đó, bạn có thể đặt câu hỏi về nội dung video.

Sử dụng Chat with RTX để tóm tắt video YouTube

Sử dụng Chat with RTX để tóm tắt video YouTube

Đánh Giá Chat with RTX

Chat with RTX là một lựa chọn đáng giá mặc dù có sự cạnh tranh từ các chatbot AI khác. Một trong những điểm mạnh lớn nhất của Chat with RTX là khả năng sử dụng RAG mà không cần gửi dữ liệu của bạn đến máy chủ của bên thứ ba, đảm bảo an toàn dữ liệu. Ngoài ra, Chat with RTX hoạt động tốt hơn và nhanh hơn so với các chatbot AI khác chạy Mistral 7B nhờ vào việc sử dụng TensorRT-LLM và RTX acceleration.

Giải Pháp Nếu Không Có GPU RTX 30 hoặc 40 Series

Nếu bạn không có GPU RTX 30 hoặc 40 Series, bạn vẫn có thể chạy LLM trên máy tính của mình bằng cách sử dụng các giải pháp khác như GPT4ALL hoặc Text Gen WebUI. GPT4ALL cung cấp trải nghiệm plug-and-play, trong khi Text Gen WebUI cung cấp khả năng điều chỉnh và linh hoạt hơn cho những người dùng có kỹ thuật.

-

Chat with RTX có yêu cầu kết nối internet không?

- Không, Chat with RTX có thể hoạt động hoàn toàn offline.

-

Tôi có thể sử dụng Chat with RTX để phân tích video YouTube không?

- Có, bạn có thể sử dụng tính năng YouTube URL để phân tích video YouTube.

-

Chat with RTX có an toàn cho dữ liệu cá nhân không?

- Có, vì Chat with RTX chạy trực tiếp trên máy tính của bạn, dữ liệu của bạn sẽ không được gửi đến bất kỳ máy chủ nào khác.

-

Tôi cần loại GPU nào để chạy Chat with RTX?

- Bạn cần GPU RTX 30-Series hoặc 40-Series để chạy Chat with RTX.

-

Chat with RTX có thể làm gì với các tệp dữ liệu của tôi?

- Chat with RTX có thể đọc và phân tích các tệp dữ liệu của bạn để cung cấp câu trả lời cá nhân hóa thông qua tính năng RAG.

-

Có thể sử dụng Chat with RTX để tạo mã lập trình không?

- Có, bạn có thể sử dụng Chat with RTX để tạo mã lập trình dựa trên các tệp dữ liệu bạn cung cấp.

-

Chat with RTX có phải là phiên bản demo không?

- Phiên bản hiện tại của Chat with RTX là một bản demo, nhưng các phiên bản sau này sẽ được tối ưu hóa hơn.

Kết Luận

Chat with RTX là một công cụ mạnh mẽ và an toàn để chạy LLM trên máy tính cá nhân của bạn. Với khả năng cá nhân hóa câu trả lời thông qua RAG và hiệu suất cao nhờ vào công nghệ của Nvidia, Chat with RTX là một lựa chọn tuyệt vời cho những ai muốn tận dụng sức mạnh của AI mà không cần lo lắng về bảo mật dữ liệu.

Hãy thử ngay Chat with RTX để trải nghiệm sự tiện lợi và an toàn mà nó mang lại. Đừng quên khám phá thêm nhiều bài viết hữu ích khác tại Tạp Chí Mobile và theo dõi các tin tức công nghệ mới nhất tại Tech.